Одним важных шагов в направлении эффективного продвижения сайта является его индексация. Этот процесс определяет, как быстро пользователи смогут найти ваш сайт, что делает индексацию ключевым фактором в веб-пространстве.

Процесс индексации

Роботы-краулеры, такие как ЯндексBot и GoogleBot, играют решающую роль в индексации сайтов. Эти алгоритмы сканируют содержимое веб-страниц, передавая информацию алгоритмам поисковика. Это важное звено в цепочке взаимодействия, определяющем успешность сайта в поисковой выдаче.

Оценка и индексация

После сканирования информации краулер передает ее алгоритмам поисковика для оценки. Алгоритмы используют различные параметры для определения качества страницы. Некоторые из этих параметров технические, такие как предотвращение дублирования контента, исключение сайтов с мошенническим содержанием.

Важные факторы, на которые стоит обратить внимание, включают в себя количество ключевых слов, уникальность контента и его полезность для пользователей.

Факторы оценки качества контента

-

Ключевые слова. Фразы, которые пользователи вводят в поисковую строку. Контент, содержащий ключевые слова, более точно распознается алгоритмами и поднимает сайт в результатах поиска. Однако, важно избегать переспама, т.е. избытка ключевых слов, чтобы не нарушить баланс и читаемость текста.

-

Уникальность. Алгоритм считает контент неуникальным, если он повторяет материал со сторонней страницы. Это может привести к бану сайта. Таким образом, поддерживать высокую уникальность контента важно для успешной индексации.

-

Польза. Алгоритм добавляет страницу в каталог, если контент на ней полезен для пользователей. Это включает в себя актуальность информации, ответы на вопросы, структурирование контента и предоставление практических советов или рекомендаций.

Как ускорить индексацию

Чем быстрее поисковые системы включат страницу в индекс, тем быстрее она станет доступной для посетителей. Для ускорения процесса индексации рекомендуется следовать нескольким стратегиям:

-

Добавление сайта через сервисы для веб-мастеров. Почти у всех поисковиков есть свои сервисы для веб-мастеров, такие как Google Search Console и Яндекс.Вебмастер. Эти инструменты позволяют вам отправить ссылки на страницы для индексации.

-

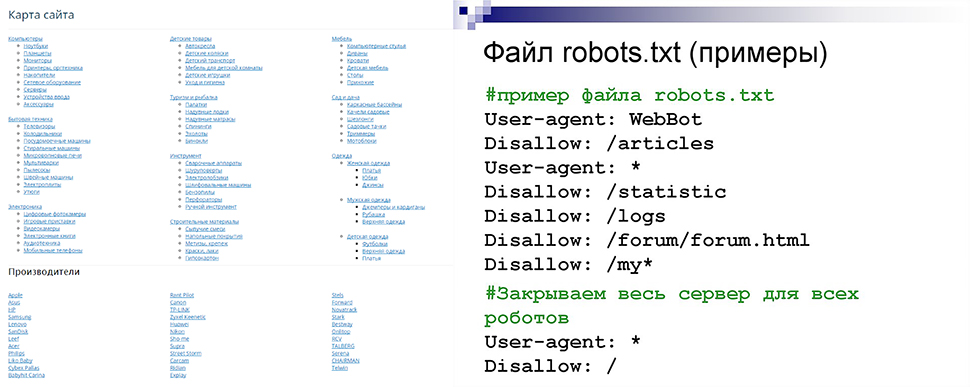

Указание ссылок на файлы Sitemap и robots.txt: В Search Console и Яндекс.Вебмастере. Можно указать ссылки на файлы Sitemap и robots.txt. Это помогает поисковым системам регулярно сканировать ваш сайт и обновлять информацию в индексе.

-

Регулярное добавление нового контента. Свежий и уникальный контент привлекает внимание краулеров. Регулярное добавление материала на сайт способствует более активной индексации.

-

Перелинковка страниц. Создание внутренних ссылок между страницами сайта помогает краулерам быстрее обнаруживать новые материалы.

-

Распространение через социальные сети и другие сайты. Размещение ссылок на новые страницы в социальных сетях и на других сайтах также способствует их быстрой индексации.

Как проверить индексацию сайта

-

С использованием Яндекс.Вебмастера и Search Console. В этих инструментах есть специальные функции для проверки статуса URL и индексации страниц. Просто добавьте ссылку на нужную страницу, чтобы узнать ее статус в поисковой системе.

-

С использованием команды "site". Если вы не хотите использовать сервисы для веб-мастеров, вы можете проверить индексацию страниц с помощью команды "site:" в поисковых системах. Например, введите "site:ваш-сайт.ру" (без кавычек) в поиске, чтобы увидеть все проиндексированные страницы.

-

С использованием сторонних сервисов. Существуют различные сторонние сервисы, такие как Серпхант, которые позволяют проверить индексацию нескольких страниц одновременно.

Закрытие страниц от индексации

Иногда существуют страницы, которые не предназначены для показа в результатах поиска или могут содержать конфиденциальную информацию. Чтобы предотвратить их индексацию, можно использовать различные методы.

-

Использование Robots.txt. Файл robots.txt представляет собой текстовый файл, который веб-мастер размещает на своем сервере. Он содержит инструкции для поисковых роботов, указывая, какие страницы следует сканировать, а какие нет. С использованием директивы "Disallow", можно запретить индексацию конкретных страниц или целых разделов сайта.

-

Мета-тег noindex. Вставка мета-тега "noindex" в HTML-код страницы является еще одним методом предотвращения индексации. Этот тег сообщает поисковым роботам, что данная страница не должна включаться в индекс поисковой системы.

-

Использование авторизации. Некоторые страницы могут быть закрыты от поисковых роботов формой авторизации. Если доступ к содержимому страницы предоставляется только зарегистрированным пользователям, поисковые роботы не смогут ее проиндексировать.

Заключение

Процесс индексации сайта является неотъемлемой частью оптимизации работы поисковых систем. Этот процесс обеспечивает эффективное сканирование и анализ контента веб-ресурсов, что позволяет поисковым системам предоставлять пользователям релевантные и качественные результаты поиска.

Важно подчеркнуть, что индексация не является статичным процессом. Краулеры регулярно обходят страницы для обновления информации, и каждое внесенное изменение может повлиять на ранжирование. Поэтому постоянное внимание к качеству контента, техническим аспектам и стратегии SEO